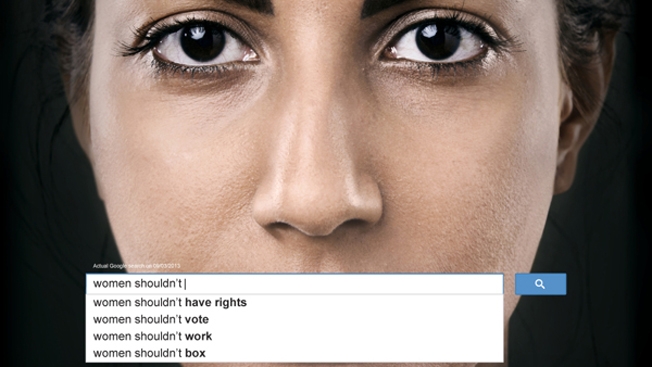

Au cours des dernières semaines, la branche des Nations Unies – ONU Femmes a lancé une campagne contre le sexisme, qui en a inspiré une autre contre l'homophobie. Dans les deux cas, on utilise une capture d'écran d'une recherche Google. Vous savez, quand on tape quelques lettres ou quelques mots et que Google «autocomplète» et fait des suggestions basées sur les recherches les plus populaires? Soudainement, j'ai un peu mal à l'humanité. Il se trouve qu'il y a pas mal de monde qui «googlent» leurs préjugés. Le genre de propos qui ne se disent pas à haute voix, mais qui se «cliquent» bien derrière son écran d'ordinateur, sans la pression de la conformité sociale, ni jugement. Voici ce que ça donne.

Des phrases comme «Women shouldn't have rights», «Women shouldn't vote», «Women should be in the kitchen». Les détails ICI.

Les recherches homophobes sont tout aussi révoltantes «Gays shouldn't marry», «Gays shouldn't adopt» et la pire «Gays should be put to death». On peut voir le tout ICI.

CBC a répété l'exercice. Pas glorieux là non plus. Ce n'est d'ailleurs pas mieux en français, Marie-Claude Lortie a fait le test dans La Presse. La porte-parole de Google lui a assuré que ce n'est pas un choix éditorial, que c'est strictement fait pour accélérer la recherche et que le tout est basé sur un certain nombre de facteurs, dont la popularité des mots cherchés. C'est d'autant plus décourageant. Je me questionne quand même sur la responsabilité sociale du populaire moteur de recherche dans tout ça. Algorithmes ou pas, «autocomplète» véhicule des stéréotypes. Il y a quand même une bonne nouvelle, des internautes ont bombardé Google de recherches avec des messages plus positifs pour contrebalancer le tout, et ça a marché. Yé!

Reste que pour illustrer tout le travail qu'il reste à faire pour combattre les préjugés, ces campagnes des Nations Unies sont franchement réussies.

Qu'en pensez-vous?